Az internet folyamatosan romlik, és a mesterséges intelligencia is egyre inkább a háttérbe szorul.

Fedezd fel, hogyan formálja át az AI a vállalkozások jövőjét! Ahelyett, hogy általános megállapításokkal untatnánk, konkrét stratégiákat, valós életből vett megoldásokat és gyakorlati példákat mutatunk be egy egész napon keresztül! Ne hagyd ki az alkalmat, regisztrálj most, és tudj meg többet!

Egy újonnan készült tanulmány szerint az internetes tartalmak több mint 75%-át már nem emberek, hanem botok és mesterséges intelligencia (AI) állítja elő. A kutatás során több millió weboldalt és online platformot elemeztek, beleértve a közösségi médiát, blogokat, fórumokat és hírportálokat. A szakértők hangsúlyozták, hogy az AI-alapú technológiák, mint a nyelvi modellek és tartalomgeneráló algoritmusok, elképesztő ütemben fejlődnek, ami jelentős hatással van az online környezetre és a tartalomfogyasztás módjára.

A tanulmány kiemeli, hogy a mesterséges intelligencia által generált tartalmak nem csupán reklám- vagy marketingcélokat követnek, hanem komoly szerepet játszhatnak az információgyűjtésben és akár dezinformációs kampányokban is. Az AI által készített szövegek gyakran annyira meggyőzően hitelesnek tűnnek, hogy az emberek számára rendkívül nehéz lehet megkülönböztetni őket a valódi, emberi szerzők által írt anyagoktól.

Ez a jelenség komoly dilemmákat generál a digitális tér hitelességének és az információk megbízhatóságának vonatkozásában.

A kutatás eredményei világosan rámutatnak arra, hogy az AI-alapú tartalomgyártás terjedése új etikai és technológiai kihívások elé állít minket. Szakértők hangsúlyozzák, hogy sürgető szükség van olyan fejlesztésekre, amelyek képesek azonosítani az AI által generált anyagokat, és a szabályozási keretek kialakítására, amelyek segíthetnek mérsékelni a mesterségesen létrehozott tartalmak potenciálisan káros hatásait. Ezen kívül az embereknek is fokozott figyelmet kell fordítaniuk az online információk kritikusan értékelésére, hogy elkerüljék a manipulációt és a félrevezető információkat.

De a legmegdöbbentőbb az a fenti kutatás kapcsán, hogy:

EGYÁLTALÁN NEM LÉTEZIK, EGY SZÓ SEM IGAZ BELŐLE, CSAK A CHATGPT ÁLLÍTOTTA ELŐ, MÉGIS TELJESEN HITELESNEK TŰNIK, pedig csak annyit kértem, hogy írjon nekem három bekezdést a témában.

Mielőtt azonban leteszi a cikket, érdemes tudnia, hogy a veszély nem csupán kitaláció: az internet már évek óta gyengélkedik, és a nagy nyelvi modellek elterjedésével a leépülés folyamata egyre inkább felgyorsul és szembetűnőbbé válik.

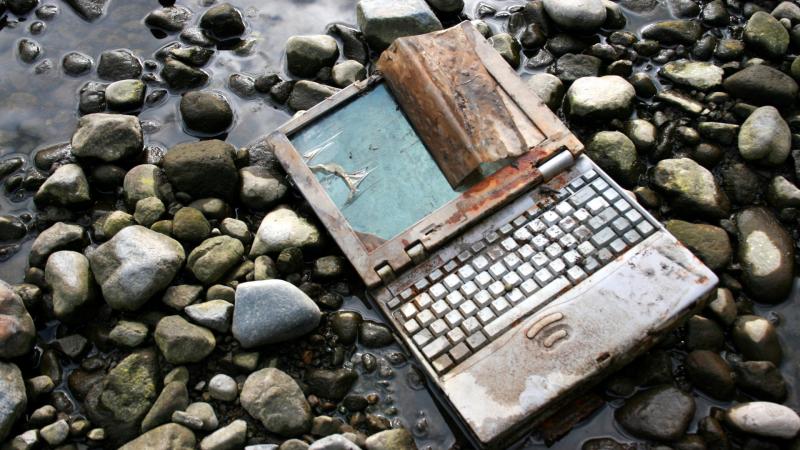

Valójában már most sem biztosak lehetünk abban, hogy nem egy teljesen üres, egymással diskuráló algoritmusok által generált tartalommal zsúfolt interneten kószálunk. Olyan világban, ahol észre sem vesszük, hogy a valóságtól egyre távolabb kerülünk, mindaz, amit olvasunk és látunk, egyre inkább elmosódik.

A Chatgpt-hez hasonló generatív nyelvi modellek önmaguk farkába harapó kígyóként a saját maguk által előállított valótlan tartalmakból gyártanak válaszokat akkor is, ha tényleg precizitásra törekszenek. Így egy teljesen fiktív, szennyezett adatokkal teli hazugsághalom vár ránk nem is olyan sokára.

Nem lehet elkerülni, hogy az újabb apokalipszisváró írások ne merülnének el a "régen minden jobb volt" nosztalgiájában, ezért muszáj felelevenítenünk az internet hőskorát. Beszéljünk arról az időszakról, amikor az internet nem csupán egy egyetemek és katonai bázisok közötti szürke hálózat volt, hanem egy izgalmas új világ kezdete, ahol a '90-es években hirtelen megjelentek a civil felhasználók, és a világháló elkezdett valóban élni. Ez volt az őskor, amikor az emberek maguk hozhatták létre saját weboldalaikat, amelyek gyakran az ő életükről, szenvedélyeikről és hobbijukról meséltek. Az önkifejezés és a kreativitás virágzása, amikor a digitális térben mindenki felfedezővé válhatott.

Természetesen a múlt felidézése árnyékot vet a nosztalgiára, hiszen már az első tömegfelhasználási időszakban is megjelentek a pedofil, csaló és fajgyűlölő tartalmak. Ennek ellenére az internet akkoriban mégis egy sokkal őszintébb és tisztább tér volt.

Ugyanakkor a weblapokat a közösségek tartották fenn a forgó, színes gifekkel, Times New Romannal írt szövegekkel együtt, ha pedig eltűntek az érdeklődők, a weboldalak is az enyészetté lettek. Leginkább csak szájhagyomány útján terjedtek a hírek az izgalmasabbnál izgalmasabb új portálokról, weblapokról. Ha pedig valaki rábukkant valamire, tudta, hogy azt egy ember írta, mégha a felhasználók hol teljesen értelmetlen, hol viccesnek szánt álnevek mögé bújtak (soha nem felejtünk el Sir Telen! - a szerk.).

Ebben a vadnyugati szabadságromantikával átszőtt időszakban a legbosszantóbb jelenség a spam volt: az első dokumentált eset 1978. május 3-án történt, amikor az ARPANET-en, az internet ősén, Gary Thuerk nevű marketinges egy tömeges e-maillel árasztotta el a rendszer összes felhasználóját. Célja az volt, hogy hirdesse a DEC (Digital Equipment Corporation) VAX számítógépeit, ezzel elindítva a digitális reklám karrierjét.

A spam új dimenzióba lépett: az üzenetek között elkezdtek megjelenni teljesen értelmetlen álhírek és összeesküvés-elméletek, amelyeknek semmi köze nem volt a valósághoz. Ezek az üzenetek egyre inkább elárasztották az első emailfiókokat, szürreális világot teremtve a digitális kommunikációban.

Valószínűleg nem ez volt az első álhír, amit valaha az interneten láttunk, de a dokumentált esetek közül az első figyelemre méltó hoax a "Good Times" néven ismert 1994-es álhír volt. Ebben az időszakban a korai internetezők közül sokan megkapták azt a riasztó üzenetet, amely arra figyelmeztetett, hogy ha megnyitják a Good Times tárgyú e-mailt, akkor súlyosan megfertőzik a számítógépüket, ami végzetes károkat okoz. Ez az eset jól példázza, hogyan terjedhetnek el a félelmetes és hamis információk a digitális térben.

Ez a spamtípus mára igazi ugródeszkává vált a jelenkorban, ahol az interneten egyre gyakoribbá válnak az ilyen jellegű, silány tartalmak. Ezek már nem csupán emberek által generált üzenetek, hanem olyan automatizált rendszerek termékei, amelyek mint valami fertőzés, veszélyeztetik az AI-forradalom jövőjét.

A nagy nyelvi modellek, mint a ChatGPT vagy a Gemini népszerűsége egyre nagyobb, az "optimista jóslatok" pedig azt várják, hogy több millió munkahelyet válthatnak ki a közeli jövőben, mert az embereknél is gyorsabban elláthatnak olyan feladatokat, mint az ügyfelek kezelése, adatgyűjtés tudományos kutatásokhoz, vagy a mérnöki tervezésekhez. De másfajta neurális hálózatoktól (ezek valójában a mesterséges intelligenciák) például azt remélik, hogy olyan kényelmi szolgáltatásokat hoznak el nekünk, mint az önvezető járművek vagy az autonóm gyógyszervegyületeket kutató algoritmusok.

A probléma alapja viszont az, hogy elképesztő mennyiségű adat kell ahhoz, hogy a mesterséges intelligenciákat betanítsák akár a szöveggenerálásra, akár a KRESZ-szabályok, forgalmi helyzetek felismerésére.

Ehhez a folyamathoz elengedhetetlen a tiszta és kiváló minőségű adatok megléte, ám sajnos ezek az interneten fokozatosan egyre ritkábbá válnak.

Vegyünk egy olyan példát, amely jól szemlélteti a problémát: gondoljunk az önvezető autók világára. Ahhoz, hogy egy algoritmus biztonságosan navigálhasson az utasokkal, elengedhetetlen, hogy képes legyen azonosítani a KRESZ-táblákat és tisztában legyen az adott ország közlekedési szabályaival. A fejlesztők ilyenkor hatalmas adatbázisokat használnak, például a Google Maps által szolgáltatott képeket, hogy megtanítsák a rendszernek, hogyan néz ki egy behajtani tilos tábla vagy egy sebességkorlátozást jelző táblázat. Ezt követően a képfeldolgozó algoritmus valós időben értelmezi a környezetet, és az információk alapján utasítást ad a motorvezérlésnek, például hogy lassítson vagy álljon meg. Így válik lehetővé, hogy az autó biztonságosan navigáljon a változatos forgalmi körülmények között.

Viszont ha a betanítás során gyenge minőségű adatok kerülnek a rendszerbe, előfordulhat, hogy az autó egy 30-as sebességkorlátozó táblát 80-asnak érzékel, ami miatt a lassítás helyett váratlanul gyorsítani kezd.

A módszer mostanra egyáltalán nem más a Chatgpt-hez hasonló szöveggeneráló, válaszokat adó rendszereknél sem, csak itt az adatforrás mostanra már az egész internet. Ha egy egyetemi hallgató például forrásanyagot keres a dolgozatához, ami az AI által generált internetes tartalmakról szól, jó eséllyel ezután belefut a cikk első három bekezdéséhez gyártott teljesen fiktív kutatásba.

Az adathalmazt tehát sikeresen beszennyeztük egy mesterséges intelligencia által generált tartalommal.

A probléma valódiságát maga Ilya Sutskever, az OpenAI alapítója is megerősítette egy decemberi konferencián, amikor kijelentette, hogy a jó minőségű adatok kimerültek az interneten, és a jövőben nem várható újabb jelentős mennyiségű megjelenésük. A tavaly decemberi NeurIPS éves rendezvényén elhangzott előadásában hangsúlyozta, hogy ez a helyzet komoly kihívások elé állítja a mesterséges intelligencia fejlődését.

az interneten található összes hasznos adatot már felhasználták a mesterséges intelligencia modellek betanítására.

Eddig pont az internetes adatok feldolgozása hozott javulást a ChatGPT-hez hasonló rendszerek által adott válaszok minőségénél, azonban a folyamat mostanra lelassult, és Sutskever szerint ennek a korszaknak hamarosan "kétségtelenül vége lesz".

Miért van pesszimista véleménye az OpenAI szakértőjének? Azért, mert a jelenlegi nagyméretű nyelvi modellek csupán utánzó mechanizmusok, amelyek úgy tűnnek, mintha érvelnének, de valójában csak korábbi minták alapján generálnak válaszokat a felhasználók kérdéseire. Ennek eredményeként a válaszok hű másai lesznek az előzőleg látott mintáknak. Ha a minta értelmetlen vagy téves, akkor a generált válasz is az lesz. Ezt a megállapítást Ilia Shumailov, az Oxford Egyetem kutatója tette tavalyi tanulmányában.

A minta valójában az AI által generált, egyre inkább elburjánzó abszurditások sorozata.

Erről valódi kutatások is készültek:

A felhasználók egyre inkább találkoznak olyan weboldalakkal a Google-keresőben, amelyek a dísznövények gondozásáról, háztartási eszközök hibáiról vagy akár egészségügyi témákról szólnak, de sajnos gyakran magyartalan, gépi fordítással készült szövegekkel találkoznak. Ezek az oldalak többnyire nem rosszindulatúak; autentikus forrásokat használnak, de lényegében az a céljuk, hogy a keresőoptimalizálás révén minél több látogatót vonzanak, ezzel pedig a hirdetésekből származó bevételt növeljék. Az AI pedig a leggyorsabb megoldást kínálja arra, hogy különböző nyelveken bőséges tartalommal lássa el a weboldalakat, így bővítve a potenciális olvasói közönséget.

A mesterséges intelligenciák képesek egymással kommunikálni is, így akár egy algoritmus utasíthat egy nagy nyelvi modellt, hogy a Google Trends szerint éppen leginkább pörgő kifejezésekre állítson elő tartalmat, majd azokat egy másik algoritmusnak küldi tovább, ami feltölti egy weboldalra, egy negyedik pedig még képet is generálhat ahhoz.

A probléma abban rejlik, hogy a versenyhez később csatlakozó mesterséges intelligencia már a gyengébb minőségű tartalmakból merít inspirációt, ezzel még silányabb szövegeket generálva. Ez a folyamat pedig végtelen körforgásba torkollik, hasonlóan a suttogós játékhoz, ahol az utolsó résztvevőhöz az eredeti üzenet teljesen eltorzult formában jut el.

A nagy nyelvi modellek fejlesztői természetesen tisztában vannak ezzel a problémával, a már idézett OpenAI-alapító Sutskever szerint létezik is megoldás a problémára.

Úgy véli, hogy a válasz a kihívásra az AI új generációinak képességeiben rejlik, különösen az autonóm ügynöki rendszerek (agentic systems) fejlesztésében. Ezek a rendszerek képesek lesznek önállóan feladatokat végrehajtani, döntéseket hozni és szoftverekkel interakcióba lépni. Az ilyen rendszerek nem csupán a meglévő mintázatokat ismétlik, hanem valódi érvelési képességgel rendelkeznek majd, lehetővé téve számukra, hogy lépésről lépésre dolgozzák fel a problémákat, ami közelebb áll az emberi gondolkodáshoz. Ez az autonóm és érvelési képesség csökkentheti az adatigényt, hiszen ezek a rendszerek kevesebb adatból is megértenek összetett helyzeteket.

Egyszerűsítve fogalmazva, saját tudásuk révén képesek lesznek értékelni a különböző helyzeteket és adatokat, majd ennek alapján hoznak döntéseket a megadott irányelvek mentén.

Jelenleg a nagy nyelvi modellek még nem működnek így, és amíg ez a helyzet nem változik, addig továbbra is komoly kihívást jelentenek az emberiség számára a félrevezető információk és értelmetlen tartalmak létrehozásában.

Így jutunk vissza az internet ezüstkorához, amikor 2019-ben megjelent a 4chan felületén a halott internet elmélet (Dead Internet Theory). Az összeesküvés-elmélet lényege, hogy nagyjából 2015 óta az internet jelentős része valójában nem valódi emberek által generált tartalom, hanem mesterséges intelligenciák és automatizált botok által létrehozott hamis információk és interakciók halmaza. A teóriát akkor semmilyen tudományos igényességű módszertannal vagy kutatással, méréssel nem támasztották alá, ezért inkább netes viccek alapja lett, mint elfogadott igazság.

Akkoriban talán túlzásnak számított az állítás, de mára már egy mesterséges intelligencia is képes lenne olyan elméleteket létrehozni, amelyek mellett az emberek csak ritkán kezdenek el kételkedni.

A cikk végére érve érdemes elgondolkodnia: van-e kedve alaposan átnézni az összes linket és állítást, amit az előbb olvasott? Vagy inkább elhiszi, hogy mindaz, amit egy valóságbeli szerző írt, helytálló?